L'importanza di un Ping

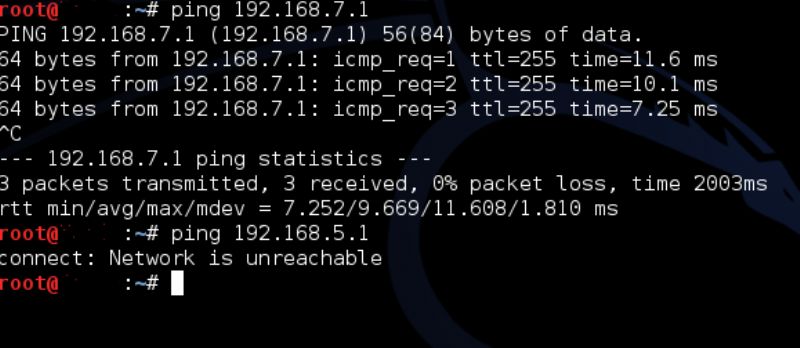

Cos'è un PING in informatica? Semplificando diciamo che un PING è un comando che invia un piccolissimo pacchetto dati ad un computer per testarne la raggiungibilità in una rete.

Nel 1986, in un Italia dove l'auto più venduta era la Fiat Uno, si andava in giro con scarpe pesantissime e "giubbotti" rigonfi, dove le giacche avevano le spalle rialzate, si guardava "Drive in" la domenica sera ed il massimo della tecnologia indossabile era un Walkman, per la prima volta fu instaurato un collegamento internet attraverso la rete satellitare atlantica SATNET con una linea da 28kbs.

Un semplice PING e l'Italia era entrata ufficialmente in ARPANET e di conseguenza nell'era di Internet.

Bisognerà però aspettare ancora più un anno (23 dicembre 1987), prima che vengano creati i domini nazioni, ".it" ( la cui gestione fu affidata al Cnuce ), affinché l'Italia entri completamente nel mondo del web con il primo dominio italiano: cnuce.cnr.it.

In un primo momento la crescita di internet in Italia fu lenta soprattutto per motivi tecnici. Le connessioni erano fatte tramite modem analogico e le velocità raramente superavano i 36Kbs: la maggior parte dei modem erano a 1200bps in ricezione e 75bps in trasmissione, il che per le reti fidonet e le BBS erano più che accettabili.

Anche l'arrivo dei modem 56Kbs non migliorarono di molto le cose, dato che oltre al costo di un abbonamento internet (intorno alle 150.000 lire annue) si doveva pagare la famigerata TUT, la tariffa urbana a tempo, tanto che i primi internauti domestici stavano con un occhio al monitor e con l'altro all'orologio.

Ma ormai la stalla era aperta e i buoi stavano uscendo.

Nel 1990 Tim Berners-Lee presso il CERN inventa un sistema per la condivisione di informazioni in ipertesto noto come World Wide Web. Insieme a Robert Cailliau, Lee mise a punto il protocollo HTTP e una prima specifica del linguaggio HTML.

Nel 1993 esce Mosaic, il primo programma a fornire uno strumento leggero di navigazione (il primo Browser per usare un termine attuale). Da quel momento non erano più solo caratteri quello che veniva ricevuto sui terminali collegati alla "Rete" ma anche immagini impaginate come in un libro e testo.

Nel 1994 nasce Video On Line che, grazie ad una sapiente campagna di marketing tramite vari periodici, tra cui Panorama, Topolino, Il Sole 24 Ore, offriva l'accesso gratuito ad internet per alcuni mesi e nel 1995 raggiunse il 30% degli utenti italiani (circa 15.000).

Da lì in poi la storia di Internet si è evoluta velocemente; alcuni progetti sono nati e scomparsi, altri sono rimasti, altri ancora si sono evoluti …

È proprio il 1995 che segna l'inizio della mia "love story" con il mondo di Internet.

In quell'anno stavo finendo il servizio militare, ma anche in quel periodo non avevo mai rinunciato a comperare riviste di informatica. Su una di queste ( non ricordo il nome) trovai per l'appunto il disco di VOL ed alla prima licenza mi fiondai davanti al computer e feci il primo collegamento tramite il mio modem a 1200bps…

… La lentezza della connessione nell'aprire la prima pagina mi lasciò leggermente deluso, abituato alle BBS dove i dati trasmessi erano solo testo e quindi la velocità del modem adeguata.

Dovetti aspettare qualche mese, dopo essermi congedato e comprai il mio modem a 36kbs con un abbonamento ad un provider locale e le cose migliorarono notevolmente.

Iniziai a studiare l'HTML e ad affascinarmi a quel linguaggio di script che permetteva di impaginare i documenti per il web.

Ma fu solo nel 2000 che veramente iniziai a lavorare in quel settore, grazie all'incontro con il Professor Pelanda.

Avevo avuto modo di conoscere il professore come mio cliente nel negozio di computer che gestivo con altri due soci e un giorno, dopo un mio intervento tecnico mi chiese se ne sapessi qualcosa di come si fanno siti web. In sincerità gli risposi che sapevo come farne uno ma non avevo mai provato realmente a farne.

Mi diede appuntamento la domenica pomeriggio per discutere.

Ricordo che stetti per quasi 40 minuti sotto il suo ufficio prima di suonare il campanello tanta era l'emozione e la paura. Dentro di me sapevo che questo avrebbe rappresentato un cambiamento nella mia vita ma non mi rendevo conto di quale potesse essere.

Il mio primo sito internet fu proprio quello del professore (www.carlopelanda.com) che negli anni ha seguito l'evoluzione del web design, a volte anche anticipando le tendenze.

La prima versione era in HTML puro, con qualche GIF animata e ottimizzato per una risoluzione di 800 x 600 pixel. Grafica semplice e colori forti ( che ancora adesso si ritrovano in alcune sezioni).

Poi fu la volta della tecnologia FLASH che permetteva animazioni complesse leggere, quindi adatte alle connessioni del tempo ( la maggior parte degli utenti web usavano ancora modem a 56KBs, solo poche aziende avevano la linea ISDN e la Tariffa Urbana a Tempo era ancora attiva sulle linee telefoniche).

Attualmente si usano i CSS e l'HTML5, con java script.

Abbiamo abbandonato i fronzoli delle animazioni iniziali per dare più spazio ai contenuti e l'integrazione con i social network.

Sempre una maggior parte delle utenze internet utilizza anche dispositivi mobili, quindi la necessità è diventata quella di ottimizzare la visualizzazione su tablet e smartphone, così , come da una grafica ottimizzata per una risoluzione di 800x600 pixels siamo passati ad una di 1024x768, adesso passiamo ad una grafica fluida che si adatta a dispositivi mobili ed a schermi HD che arrivano anche 1600pixels.

Il web è come un essere vivente che si evolve. Un media che, a differenza della radio, della televisione o dei giornali, continua a crescere e cambiare.

Tornando al 1986 solo pochi scrittori di fantascienza ( tra i quali William Gibson esponente di spicco del filone cyberpunk. ) potevano immaginare quale futuro ci aspettava.

In questa rubrica ho parlato spesse volte di tecnologie web che nascono, fanno il loro exploit e poi spariscono, lasciando però una traccia indelebile ed una guida per il futuro.

È del futuro del web che adesso parlo.

Possiamo fare scenari ed ipotizzare come la nostra vita potrà cambiare, ma non possiamo esserne certi.

Con l'avvento delle connessioni ADSL e FLAT sempre più persone hanno accesso al web e di queste sempre più si esprimono tramite questo mezzo, influenzandone le tendenze.

Il fatto di essere un mezzo di comunicazione a due vie (ricevo informazioni ma ne mando anche) porterà internet ad essere una specie di coscienza collettiva di grande magazzino dove si attinge agli archetipi societari.

Nessuno poteva immaginare il successo dei Social Network come Facebook e Twitter e l'influenza che hanno avuto nella vita di tutti i giorni o il declino di siti come Second Life, che invece si prevedeva avrebbe raggiunto milioni di utenti attivi.

Il futuro è da scrivere e se gli anni '90 hanno rappresentato il momento di boom di internet, il XXI secolo rappresenterà la sua età matura.

Per finire, riporto le parole del Professor Pelanda all'inizio del nostro rapporto di collaborazione:

"… Dipinta questa, metterei accanto il viso di Filippo, giovante tecnico computer veronese. Si è offerto di costruire il sito (www.carlopelanda.com) dove tra poco sbatterò tutte le mie pubblicazioni e farò pubblicità alla mia attività (scenaristica). Stavo per firmare il contratto con un'azienda milanese che mi proponeva la realizzazione del sito (complesso e non solo una semplice videata web) ad un buon prezzo ed in pochi giorni. Ma ho assunto Filippo, che mi costa un po' di più e allunga di tre mesi i tempi perché non ha ancora un'esperienza di questi lavori, pur geniale tecnico. Sono rimasto affascinato dalla sua volontà di imparare questo mestiere e colpito dalla mancanza di risorse educative che glielo insegnassero, qui nella nostra zona. Abbiamo fatto un patto: impara lavorando ed io accetto il rischio. In cambio mi assisterà nella gestione futura del sito a costi inferiori a quelli di mercato. Ed il suo viso – simpaticissimo e concentrato, teso nello sforzo – possiamo metterlo tra l'immagine ansiosa detta sopra e lo scenario piacevole di sfondo futuro."

(L'Arena 20/04/2000)